Twierdzenie, że cudze opinie nie podlegają krytyce, wcale nie jest wyrazem szacunku. Przeciwnie – to przejaw dehumanizacji.

Załóżmy, że błędy zostałyby zniesione. Kim byłby człowiek, który nigdy się nie myli? Na to pytanie można udzielić dwóch całkowicie różnych odpowiedzi. Z jednej strony możemy pomyśleć o nadczłowieku, istocie podobnej Bogu. Do takiej wizji odwołuje się wers z poematu O krytyce Aleksandra Pope’a: „Zbłądzić jest to rzecz ludzka, a Boska przebaczyć” [tłum. Ludwik Kamiński]. Bóg przebacza, ale sam nie jest w stanie popełnić błędu. Wydaje się, że wszechwiedza i nieskończona mądrość nieuchronnie wiążą się z nieomylnością.

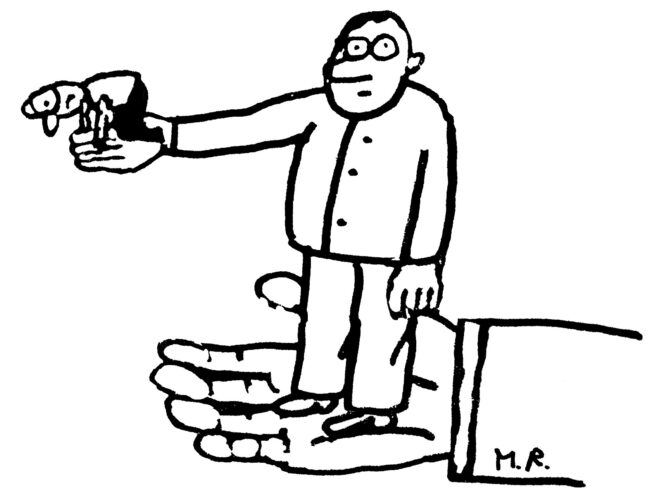

Z drugiej strony może przyjść nam do głowy przeciwieństwo nadczłowieka – istota, która zasadniczo jest bezmyślna. W latach 90. komik Bill Hicks zarzucił mało bystrym widzom, że gapią się na niego jak „pies, któremu pokazano sztuczkę karcianą”. Porównanie przywołuje postać nieszczęsnego magika, który marnuje swój kunszt na bezrozumne stworzenie. Hicks po części wyśmiewał samego siebie – przecież tylko frajer podjąłby się tak bezsensownego zadania. W jego słowach jednak kryła się druzgocąca krytyka publiczności. Zarzucał jej bowiem głupotę, znacznie większą niż jego frajerstwo.

Przecież oglądamy magiczne sztuczki właśnie po to, aby nas przechytrzono. Ale żeby tak się stało, najpierw musimy z nich cokolwiek rozumieć, np. założyć, że magik rzeczywiście umieścił z powrotem w talii kart dziesiątkę kier. Przysłowiowy pies nie będzie się nad tym zastanawiał, bo kawałki tektury z symbolami nic dla niego nie znaczą. Dzięki temu nie pozwoli się oszukać. Hicks dał jasno do zrozumienia, że widzom – podobnie jak psu – brakuje bystrości, aby podążać za jego żartami, a więc by dać się nabrać. W tym kontekście zatem skłonność do popełniania błędów i przyjmowania fałszywych założeń raczej świadczy o naszej zdolności do myślenia, niż jej zaprzecza.

Badacze układu wzrokowego człowieka również wskazują na związek między zdolnością do popełniania błędów a myśleniem. Spójrzmy na zamieszczony poniżej rysunek stworzony przez Edwarda Adelsona, neurologa z Massachusetts Institute of Technology. Przedstawia on obiekt rzucający cień na szachownicę. Pole B, znajdujące się w cieniu, wydaje