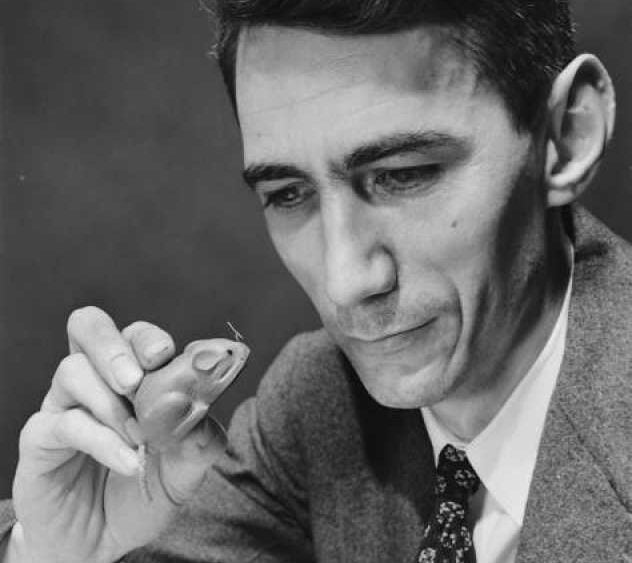

Nauka próbuje odkryć podstawowe prawa natury, matematycy poszukują nowych twierdzeń, inżynierowie tworzą systemy służące zaspokajaniu ludzkich potrzeb. Wszystkie te trzy dyscypliny są ze sobą wzajemnie powiązane, ale zachowują odrębność i bardzo rzadko zdarza się, że jeden człowiek wnosi ogromny wkład w każdą z nich. Claude Shannon był jednak wyjątkowy.

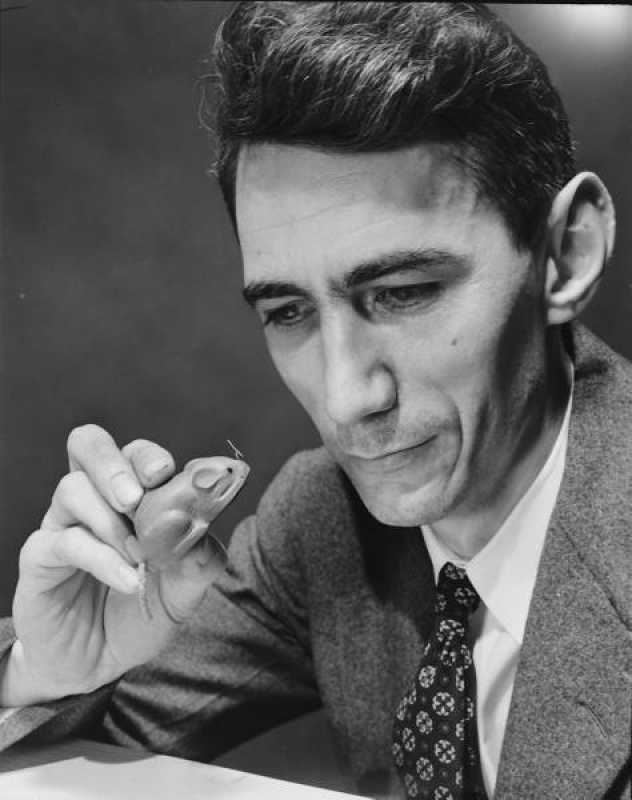

Nie zyskał powszechnej sławy, choć niedawno nakręcono o nim film dokumentalny zatytułowany The Bit Player. Nigdy nie zdobył Nagrody Nobla, a poza tym ani za życia, ani po śmierci (umarł w 2001 r.) nie stał się naukową gwiazdą jak Albert Einstein czy Richard Feynman. Ale to właśnie on przeszło 70 lat temu opublikował artykuł, w którym położył fundamenty ery informacji oraz infrastruktury komunikacyjnej dzisiejszego świata.

Shannon urodził się w Gaylord w stanie Michigan w 1916 r. Był synem miejscowego przedsiębiorcy i nauczycielki. Na Uniwersytecie Michigan uzyskał dyplomy z inżynierii elektrycznej i matematyki, następnie zaś podjął studia magisterskie w Massachusetts Institute of Technology. W swojej rozprawie zastosował algebrę Boole’a do analizy i syntezy komutacji obwodów. Była to przełomowa praca; projektowanie obwodów zyskało ścisłe, naukowe podstawy. Obecnie uważa się, że rozprawa Shannona to początek historii obwodów cyfrowych.

Następnie uczony zajął się bardziej ambitnym zagadnieniem: komunikacją.

Komunikacja należy do podstawowych potrzeb człowieka. Począwszy od sygnałów dymnych i gołębi pocztowych aż po telefon czy telewizję, ludzie zawsze próbowali opracowywać metody pozwalające im wysyłać wiadomości dalej i szybciej, a także zwiększające prawdopodobieństwo, że przekaz dotrze do odbiorcy. Wszystko to miało jednak charakter praktyczny. Inżynierowie opracowywali systemy komunikacyjne z myślą o konkretnych nadawcach i wykorzystywali konkretne, fizyczne nośniki. Shannon natomiast zadał sobie pytanie: „Czy da się stworzyć ogólną, jednolitą teorię komunikacji?”. W 1939 r. wyłożył swoje wstępne pomysły dotyczące „zasadniczych cech systemów transmitowania wiedzy” w liście do Vannevara Busha, którego uważał za mentora. Po bezmała 10 latach pracy, w 1948 r., Shannon opublikował wreszcie artykuł arcydzieło, zatytułowany Matematyczna teoria komunikacji.

Jej jądrem jest prosty, ogólny model. Transmiter koduje informację i przekształca ją w sygnał. Ten ulega zaburzeniom na skutek entropii, następnie zaś zostaje rozkodowany przez odbiornik. Cały model wydaje się nieskomplikowany, ma jednak dwie niezwykle ważne cechy. Po pierwsze Shannon oddzielił źródła informacji i entropii od konkretnego, fizycznego systemu komunikacji. Po drugie obydwa rodzaje źródeł modelował probabilistycznie. Założył, że nadawca zawsze generuje jeden z wielu możliwych komunikatów. Skoro tak, każdemu komunikatowi da się przypisać określone prawdopodobieństwo. Entropia dodaje nieco losowego szumu (jego prawdopodobieństwo można szacować), który następnie musi zostać uwzględniony w procesie odkodowywania komunikatu przez odbiornik.

Zanim Shannon opublikował swój artykuł, komunikację postrzegano w kategoriach deterministycznych. Podstawowe pytanie brzmiało: w jaki sposób przekształcić otrzymany sygnał zaburzony przez fizyczne medium komunikacji, by odtworzyć pierwotnie wysłaną informację tak wiernie, jak to tylko możliwe? Shannon poczynił jednak genialne spostrzeżenie: kluczem do komunikacji jest niepewność. Przecież gdybyście od początku wiedzieli, co zamierzam napisać w tym artykule, jego publikowanie nie miałoby sensu.

Dzięki tej jednej obserwacji Shannon sprawił, że problem komunikacji można było teraz rozpatrywać w kategoriach abstrakcyjnych, w oderwaniu od konkretnego, fizycznego medium. Niepewność dało się zaś modelować, używając probabilistyki. Dla ówczesnych inżynierów, zajmujących się komunikacją, był to prawdziwy wstrząs.

Skoro kategorie niepewności i prawdopodobieństwa odgrywały w teorii Shannona zasadniczą rolę, uczony podjął w swoim artykule próbę ustalenia zasadniczych ograniczeń komunikacji. Wnioski podzielił na trzy części. Najważniejszym ich elementem była koncepcja bitu, który Shannon określił mianem podstawowej jednostki niepewności. Bit, czyli „binary digit”, może mieć wartość 0 lub 1. Artykuł Shannona był pierwszą publikacją naukową, w której padło to słowo (aczkolwiek pojawiło się ono wcześniej w notatce matematyka Johna Tukeya).

W pierwszym kroku Shannon opracował wzór na entropię, której wartość zapisywał literą H, by określić poziom niepewności przy ustalaniu, który z możliwych komunikatów wygeneruje źródło. Im mniejsza entropia, tym mniejsza niepewność, a więc tym łatwiej skompresować komunikat. Przykładowo, jeśli mamy minutę na napisanie esemesa składającego się równo ze 100 liter podstawowego alfabetu łacińskiego, daje nam 26¹⁰⁰ możliwych wiadomości. Do zakodowania ich wszystkich potrzeba 470 bitów, gdyż 2⁴⁷⁰ ≈ 26¹⁰⁰. Oznacza to, że entropia wynosi 470 bitów na minutę. Ale tylko w teorii. W prawdziwym świecie niektóre kombinacje liter w twoim esemesie są bardziej prawdopodobne niż inne, więc entropia jest znacznie niższa, co umożliwia większą kompresję.

Po drugie Shannon przedstawił wzór na maksymalną liczbę bitów na sekundę, które można przesłać mimo szumu i liczyć, że zostaną odpowiednio rozkodowane. Nazwał to potencjałem systemu (C). Mówiąc inaczej: C to maksymalne tempo, z jakim odbiornik może uporać się z niepewnością. W zasadzie C oznacza górną granicę prędkości przesyłania informacji.

Po trzecie Shannon wykazał, że rzetelne komunikowanie informacji w obliczu entropii jest możliwe wtedy i tylko wtedy, gdy H < C. Przywołajmy proste porównanie: jeśli przepływ wody jest mniejszy niż przepustowość rury, wszystko dobrze działa. W przypadku informacji mamy do czynienia z identyczną regułą.

Przedstawiona tu teoria nie dotyczy tylko komunikacji, ale też informacji, a zwłaszcza jej generowania i przekazywania. Właśnie dlatego Shannon uchodzi dziś za „ojca teorii informacji”.

Twierdzenia, które przedstawił, prowadzą niekiedy do nieintuicyjnych wniosków. Załóżmy, że prowadzisz rozmowę w jakimś bardzo hałaśliwym miejscu. Jak zadbać, by twój komunikat dotarł do odbiorcy? Pierwsza myśl: powtórz go kilkakrotnie. Ale metoda ta okazuje się mało wydajna. Owszem, im więcej razy powtarzasz komunikat, tym większe prawdopodobieństwo, że odbiorca go usłyszy, lecz komunikacja będzie przebiegała znacznie wolniej. Shannon pokazał, że istnieją lepsze sposoby. Można np. wykorzystać inny, bardziej wyrafinowany kod. Pozwoli to na szybszą komunikację – oczywiście w ramach limitu wyznaczonego przez C – a zarazem zachowanie tego samego poziomu rzetelności.

Inny niespodziewany wniosek wypływający z teorii Shannona brzmi następująco: bez względu na charakter informacji największą wydajność osiągamy, jeśli przed transmisją zakodujemy ją w postaci bitów. Nie ma znaczenia, czy chodzi o sonet Shakespeare’a, symfonię Beethovena czy film Kurosawy. Weźmy choćby system radiowy. Pierwotny dźwięk i wysyłany sygnał elektromagnetyczny to analogowe fale. Jednak z twierdzeń Shannona wynika, że optymalnie będzie je najpierw zdigitalizować, czyli „przerobić” na bity, a następnie przekształcić owe bity w fale elektromagnetyczne. Ta zaskakująca konkluzja stanowi fundament ery informacji cyfrowej. Bit króluje dziś jako uniwersalna jednostka informacji.

Ogólna teoria Shannona wydaje się najzupełniej naturalna; można odnieść wrażenie, że odkrył on fundamentalne prawa rządzące wszechświatem, jak przystało na naukowca.

Aby je opisać, Shannon potrzebował nowych twierdzeń matematycznych. Wprowadził też innowacyjne koncepcje, takie jak poziom entropii w modelu probabilistycznym, stosowane później w najróżniejszych dziedzinach matematyki – np. w teorii ergodycznej poświęconej długookresowemu funkcjonowaniu systemów dynamicznych. Z tego punktu widzenia Shannon był matematykiem.

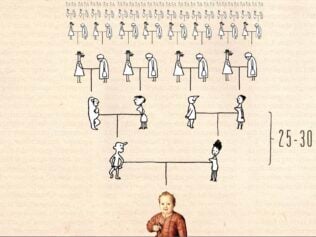

Przede wszystkim jednak należy go uznać za inżyniera. Opracował swą teorię, bo chciał rozwiązać pewne praktyczne problemy. Ówcześni inżynierowie uznali jego koncepcje za zbyt ezoteryczne, dziś jednak są one podstawą wszystkich nowoczesnych systemów komunikacyjnych: optycznych, podwodnych, nawet międzyplanetarnych. Miałem szczęście uczestniczyć w globalnych pracach, które doprowadziły do zastosowania rozbudowanej teorii Shannona w komunikacji bezprzewodowej, dzięki czemu wystarczyło kilka generacji standardów, by prędkość przesyłania informacji wzrosła o dwa rzędy wielkości. Wprowadzany obecnie standard 5G wykorzystuje dwa praktyczne kody zamiast jednego, które osiągają limit prędkości opisany przez Shannona.

Zawdzięczamy to teorii powstałej ponad 70 lat temu. Shannon skupiał się wyłącznie na zasadniczych cechach problemu i ignorował wszystko inne. Świadectwem tego jest prostota modelu komunikacji, który stworzył. Wiedział też, że należy koncentrować się na tym, co możliwe, a nie na tym, co w danym momencie da się osiągnąć.

Oto nauka w swoim najwspanialszym wydaniu. Kiedy zaczynałem studia podyplomowe, promotor powiedział mi, że najlepsze prace naukowe pozwalają przyciąć gałęzie drzewa wiedzy. Nie wiedziałem wówczas, o co mu chodzi. Sądziłem, że moim zadaniem jest dodać tu i ówdzie kilka gałązek. Dopiero kiedy przyszło mi zastosować tę filozofię, zacząłem ją lepiej rozumieć.

Gdy Shannon zajął się komunikacją, istniało już wiele technik opracowanych przez inżynierów. Stworzona przez niego teoria oznaczała ujednolicenie całej dyscypliny, przycięcie gałęzi tak, by na koniec zostało urocze, kształtne drzewo. Obecnie rodzi ono owoce, z których korzystają kolejne pokolenia naukowców, matematyków i inżynierów.

Pierwotnie tekst ukazał się w Quanta Magazine, niezależnym portalu internetowym Fundacji Simonsa, której misją jest poszerzanie wiedzy o nauce poprzez omawianie badań i trendów w matematyce, fizyce oraz naukach przyrodniczych. Artykuł publikujemy za zgodą redakcji Quanta Magazine. Tytuł i skróty pochodzą od redakcji „Przekroju”.